2023年のMSX40周年に向けてまたなんかやらないかな、MSX3とか

2002年から2013年あたりにかけて、MSXリバイバルの波があった。(あったということにしよう)ASCII公式エミュレーターのMSXPLAYerや、FPGAを使った1チップMSXの発売、2013年はMSX30周年だったので、ムック本やWebでの振り返り記事なども充実していた。この次に何かやるとしたら、MSにお願いしてMSXのBIOSとBASICのコードをオープンにしてもらうとか。MSX3を思い切って規格決めてみるとか(意味有るんだろうか)

ソフトウェアエミュレーターに関して、以前のMSXPLAYerのときはWindows上のアプリケーションが当たり前に使用されたのだけど、今だと他にも選択肢があると思うんだよね。Laspberry PiもMSXエミュレーションなら十分なパワーが有るし。あれにスロットつければ1チップMSX以上に融通の効くエミュレーションハードウェアとしてのMSXができるんじゃなかろうか。内蔵GPUの性能も、あきらかにV9958とかの真似をエミュレーションでやってもぜんぜんOKだろうし、V9958/V9990切り換えのAPIを構築してもいいんじゃないだろうか。

あと、turboRのR800を、ザイログのeZ80で置き換える改造とかはどうだろう。改造ってもそう簡単にいかないんじゃないかと思うのだけど、性能だけ見れば、eZ80は50MHz駆動できるし、3段パイプラインでクロックあたり3倍速。ざっとZ80 4MHzに対して30倍以上の速度を叩き出すわけで、理論値で10倍速と言われたturboRの3倍以上速くなるんじゃないだろうか。ただ32ビット乗算命令とかないので、R800モードをいかしたturboRソフトとかは動かないかもしれない。

MSXでできることはまだまだいろいろ有ると思うんだよな。できたからどうだっていう話だけど、それをやるのがマニアだろうしw。

古川享ブログのアーカイブ

古川享さんといえば日本のパソコンの歴史における生き字引みたいな人で、もとMSKKの社長→会長。日本におけるマイクロソフトの最初の総代理店、アスキーマイクロソフトにアスキーから出向、メーカー対応をメインでやってたら、代理店契約を打ち切ってMS本社が日本マイクロソフトを設立したときに引き抜かれて社長に、そしてのちに会長にと、日本におけるマイクロソフトのトップを長いこと務めてたすごい人だ。

会長辞任前後、2004年からやっていたブログは、業界の裏話なども色々あって非常に面白かったのだけど、MSがやってた独自のWindows Live Spaceというサービスの上に載っていて、このサービスが終了したことでコンテンツが失われてしまった。

その古川さんが、先日facebookの本田雅一さんの記事(東芝問題)に寄せていたコメントがすげえ興味深い話てんこ盛りで、かつての古川享ブログを思い出すものだった。ソニーのブルーレイVS東芝のHD DVDのとき、古川さんがブルーレイを押したけど、MSが東芝の嘘つきに乗せられてHD DVDを支持してて、その社内抗争的なあれで古川さんが悪いことにされそうになってやめたとか、面白すぎる話がいっぱい。

この記事読んで、「あー、デジタルテレビ規格ですげえぶっちゃけてた古川さんのブログ、また読みたいなあ」と思って探したところ、インターネットアーカイブに残ってる事がわかった。

このブログの中で「砧の某研究所」「某放送局」とあるのは基本NHKのことだ。とにかくインターレースの1080iにこだわって720pを亡き者にしようと圧力をかけてくる悪代官みたいなNHK。なんとも面白すぎる。そもそも、デジタルテレビにインターレース規格は基本不要なのだ。あれはブラウン管時代に上から下まで電子銃で捜査して蛍光体を光らせる方式では、走査線の下端に到達する頃には上端の画像が消えてしまうから、一画面の画像を飛び越しスキャンで二回上から下まで舐めて完成させるというものだ。ブラウン管時代でも末期にはフレームバッファを装備したテレビも出ていて、こうなると実質的にはインターレース表示の必要はなかったのだ。インターレース走査の表示装置というのは、要するに画面データを記憶するメモリがなく、リアルタイムで上から下まで表示しつつちらつきを押さえる必要から生まれたトリックであり、回路部品が真空管だった時代に作られた物だ。ようするに化石的規格である。現代のテレビの中身は実質パソコンであり、これが表示する画面はプログレッシブであるのが正しい。インターレースはすだれノイズの元になったり、いいことはほとんどないのだ。

当然だけど、解像度という点では、720pは1080iに劣る。ただし、1080iは地デジで確保できる転送レートではかなり厳しい規格なのだ。ちなみに現代のアニメは制作現場ではほとんど720p、1280×720で作られている。これを地デジの1080p、1440×1080にアップコンバートして放送されている。その結果帯域不足で派手な魔方陣がぐるぐる回ってビーム発射したりするシーンでブロックノイズが出ることになる。古川享さんが頑張ってNHKに抵抗した結果、720pは放送規格としては残ったのだけど、現実の放送ではCMと本編の切り替えで解像度変わったりすると一瞬表示乱れたりするかもしれないというアレで、1080iに統一されてるのが現状だ。youtubeのように、各種解像度を適切に切り替えて表示するというのはなかなか難しいのだろうなあ。

おまけ。

1080iと一言で言っても、その解像度は1440×1080、1920×1080と二種類ある。地デジは帯域が狭いので1440×1080で送出されている。ピクセルが正方形であれば、1440×1080は4:3の比率で、いわゆる昔のテレビ、スタンダードサイズになる。これを横方向に引き延ばして16:9のビスタサイズにしている。このように、地デジは出発時点で解像度を落としているのだ。今後4K、8K放送が行われるとしても、地デジの帯域では全く足りないので、おそらく10年20年過ぎた未来、テレビとは衛星放送かIPネットワークで配信される物になり、いまの地上波は遠からず廃れてしまうと思う。

トーヨーリンクスという夢の会社

かつてコダックのフィルム現像を一手に引き受けていた東洋現像所という会社があった。ここが1980年代に、コンピューターグラフィックスに乗り出す。トーヨーリンクス。現IMAGICAである。

大阪大学と組んで、日本のCGを牽引したのがトーヨーリンクス。当時グーローシェーディングやフォンシェーディングを超えて、光学を本格的にコンピューターで計算するレイトレーシングが「リアルなCGの本命」としてもてはやされていた。レイトレーシングは、画面のピクセルが空間を逆にたどって光源まで進む過程を計算し、ピクセルの色と濃度を計算するもので、フォトリアリスティックなCG作成にはこれしかないと思われていた。ただし、この技法で画面を作るには非常に計算資源を必要とし、一画面の静止画を作るのに一晩かかるような時代だった。

レイトレーシングは、画面を構成するピクセル毎に光路を計算しなければいけない。逆に言うと、ピクセル毎にコンピューターが計算すれば一瞬で一画面ができあがるのである。大阪大学とトーヨーリンクスは、かつてない大規模CPUクラスターを作成する。これがLINKS-1とLINKS-2である。

細かいことは記憶にないのだけど、LINKS-1はZ80ボードを大量にスタックしたタンスのようなコンピューターだったと思う。LINKS-2はZ8000でこれを行ってたはず。ただし、これらも1ピクセルに一つのマイコンを割り当てるほどの数はなかったと思う。たとえば640×480のピクセルを全部物理CPUに割り当てるなら、30万個のCPUが必要になる。さすがに当時そんなクラスタは組めなかった。1CPUあたり数百ピクセルレンダリングするだけでも、当時のCGとしてはかなりのハイパワーで処理できたはずだ。

僕が大学生でトーヨーリンクスの会社説明会に行った時代、おそらくZ8000ボードを数百個重ねたラックがそこにあった。まあ一部屋占拠するCGプロセッサである。1986年かそこら、アメリカでシリコングラフィックス(SGI)がCGコンピューターを開発していた時代だ。

SGIは、その後1990年代にCG用コンピューターで一世を風靡することになるが、これはあくまでジオメトリエンジンという、座標変換とシェーディングのマシン。モデリング時に高速でポリゴン表示するための物で、最終的にフォトリアリスティックな絵を作るのはあくまでレイトレーシングで、これは相変わらずうんざりするほど遅かった。

SGIが作ったジオメトリエンジンのアイデアは、後にパソコンのグラフィックボードに引き継がれ、ゲームでのリアルタイム3D表示がどんどん発展する。

これらのグラボは初期の頃、同時ポリゴン表示数などで競ってて、とてもフォトリアルな画面を作ることはできなかったが、アンチエイリアシング、バーテックスシェーダー、プログラムシェーダーと発展していくうちに、もはやかつてのレイトレーシングと同等かそれ以上のリアリティを出すことができるようになる。また、グラボの中身はあくまで画像生成の段階的回路だったものが、汎用演算器の集合になっていき、ポリゴン表示以外のベクトル計算にも使われるようになっていく。

こうなると、ようするにCPUが数百個とか数千個とか1チップに入ってるような物である。これで気づいちゃったんだろうね。数年前にNvidiaが、これを使ってレイトレーシング演算やりますってデモを公開した。

あー、つまり30年前のトーヨーリンクスの夢が、ここで実現しちゃったわけだ。長かったねえ。

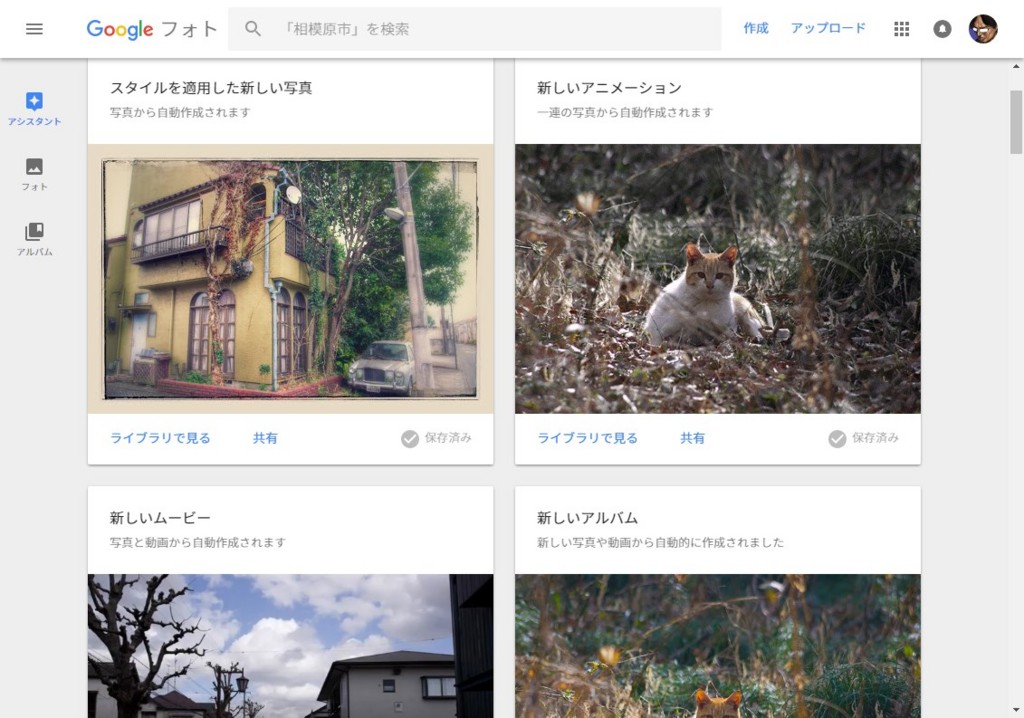

Googleフォトのおせっかいなアシスタント機能

Googleフォトの基本

Googleフォトは、無料で無制限に写真をバックアップできるGoogleのサービスだ。ただし無料だとRAWデータも高画質JPEGに変換されてしまうので、本当の意味でのバックアップとはいえない。RAWのままで保存したい場合は容量に応じた課金プランを使用する必要がある。

それはさておき、このGoogleフォト、画面の横に撮影日付が西暦表示がされ、そこをマウスでドラッグすることですばやくスクロールできるなど、なかなか操作性が良い。

また、写真の共有も簡単で、Google+、Facebook、Twitter、個人ブログなどに簡単に貼り付けることができる。ただし、PCのWebインターフェースからだと、Twitterに貼り付ける際、リンク貼り付けになってしまって画像貼り付けにならないのは残念だ。スマホアプリ版だと写真をコピーして貼り付けてくれるのだけど……

それはさておき、Googleフォトには「アシスタント」という機能があって、アップロードした写真を「勝手に」まとめてアルバムにしたり、加工したりしてくれる。使ってみて気づいたアシスタントの機能を以下に並べてみる。

アシスタント機能

アルバム

なんらかの「まとめられそうな単位で」写真をまとめてアルバムにする。「日曜日の午後、相模原市にて」「東京への旅行」などといったタイトルが入ることからして、日時、GPS情報などを調べてまとめているらしい。GPSの入っていない写真でも「旅行」などというタイトルで、確かに旅行にいったときの写真をまとめていることもあるので、画像から「旅行らしい」とGoogleのAIが判断しているのかもしれない。怖い。

例:

https://goo.gl/photos/8ZxtK88QHsnvzoyX7

ムービー

写真をスライドショー形式の動画にして、BGMをつける。写真の選択は「アルバム作成」と似たようなもので、一連の写真を並べて思い出っぽくしてくれる。BGMは数種類あるようだが、基本的にニュートラルでいかにも邪魔にならないループ系BGM。

例:

https://goo.gl/photos/9vBiJ2ttdb29uQv29

アニメーション

短い間隔で連続写真を撮ったものをつなぎ合わせてアニメーションにしてくれる。ムービーはあくまでスライドショーなのに対し、こちらは基本同じ構図の中で被写体が動いている物が採用されるらしい。パラパラ漫画的な効果を演出する。

例:

https://goo.gl/photos/TnYJ2x8n846td52H7

HDR

露出を変えて撮影した複数の同じ構図の写真があると、これをHDR合成したものを作成する。ゴーストリダクションなどは行ってくれないので、被写体が動いていると悲惨な画面になるが、アシスタントはそんなことは気にしない。

例:

https://goo.gl/photos/SQW73R2ZnectjFFa7

https://goo.gl/photos/Zj1Ku3GNbuweuUY89

パノラマ

横にずらしながら撮影した複数の写真が繋がりそうだったら合成してパノラマにする。

例:

https://goo.gl/photos/MQmJqWQUsr2etVnj8

スタイル

写真に各種フィルタ処理を施して加工する。これが発動するのは比較的珍しい。なんだろう。たまたまレトロな建物にレトロデザインの車がある写真を撮ったらインスタグラム風レトロ効果が発動したのだが、これもGoogleのAI技術だろうか。

例:

https://goo.gl/photos/UF2XLWi3E4p3ndx38

アシスタント発動条件の謎

これらのアシスタント機能、なにをアルバムにし、なにをHDRにし、なにをムービーにするかの基準は謎で、写真をアップロードした後アシスタントさんが自主申告で「新規アニメーション作りました」とか言ってくるのを待つしかない。アシスタントが作成したコンテンツは保存するかどうかが選べるので、無視すればなにも残らない。なお、アルバムくらいなら手作業でも編集できるが、HDRとかパノラマとか効果とかムービーとかアニメーションとかの機能は、アシスタントしか使えない。ムービーを見て「あ、この失敗写真削除したい」と思っても一切編集もできないし、自分で新規作成することもできない。なんとも不思議な機能である。

中世風ファンタジーで気になる白金貨

毎度「小説家になろう」等のWeb小説ネタなのだが、これも一つのテンプレなのだろうけど、Web小説の中世風「剣と魔法の世界」において、大概の場合貨幣は銅貨、銀貨、金貨、白金貨が設定されている。金貨の価値は現代の日本円にして10万円程度とされていることが多いが、金貨の上に白金貨という貨幣があり、一枚で100万円とかそれ以上の価値を持つことになっている。作品によっては金貨の上が大金貨、その上が白金貨というパターンもあり、その場合白金貨の価値は1000万円以上。通常取引に使われることはなく、大規模な不動産取引などでまれに使われるくらいのレアな貨幣になっている。

なぜそんな高額貨幣があるのかといえば、主人公は大概すごい戦闘力を持っていてそうそう狩れないドラゴンなどの上位モンスターを狩りまくったり、現代知識を生かした商品開発(リバーシなど)が大ヒットしてすごいお金を儲ける事になるためだと思うのだけど、ちょっと疑問なのは「白金貨」というものがどういう金属でできてるのか描写した作品があまりないことだ。字面からして白金、すなわちプラチナなのだろうかと思うのだけど、中世ヨーロッパ風世界の通貨として白金が出てくるとなにか違和感がある。現実の世界では、白金は古代エジプトなどで少数の使用例があり、南米などでも10世紀頃に装飾品に加工する技術があったらしいが、融点が高いため普通に溶かす火力がなかなか得られず、ヨーロッパで白金が加工できるようになるのは近代に入ってからだ。

このてのファンタジー作品では、ミスリルやオリハルコン、アダマンタイトといった希少な「ファンタジー金属」が登場することが多いが、これらが貨幣に使用されることは少なく、あくまで金貨より貴重な貨幣は「白金貨」なのだ。現実にもプラチナを使用した白金貨というものは存在するが、例えばアメリカのイーグル白金貨や、カナダのメイプルリーフ白金貨のように、額面に価格が印字されておらず、地金の価値で取引される物で、一般的な通貨として発行された物とは言えない。一般にこれらの白金貨は、金貨銀貨が本位通貨としてもはや用いられなくなった後の商品であり、きわめて現代的な印象を受ける。

つまり、中世ヨーロッパ風異世界の通貨に白金貨というものが混ざると、そこだけ中世風でもファンタジー風でもなくなる気がするのだ。

いや、最初の方で書いたとおり、「白金貨」が「白金」なのかどうかは謎なのだ。そもそも「白金貨」にルビを振っている作品を見たことがないので、読みも「はくきんか」「はっきんか」「しろきんか」どれだか判然としない。しかし、金、銀、銅が普通に現実のそれぞれに対応していると思われるので、やはり白金貨は白金なのだろうか。主人公も「え?白金?プラチナ?精錬できる炉があるの?」とか疑問に思って会話にでもしてくれれば、それへの返事から白金かどうか、白金を精錬できる技術があるのかなどの情報が明らかになって読者の方も安心できると思うのだけどなあ。

MFなオールドレンズはAFモードで使う

デジタル一眼レフで、オールドレンズを使う趣味は結構多いのだけど、その説明をしているサイトを見ると、殆どの場合カメラの設定をMFモードにするようになっている。確かにオートフォーカス非対応のレンズでオートフォーカスは効かないので間違ってはいないのだけど、実はAFモードで使うとピンぼけをかなり予防することができるのだ。

なお、僕はPENTAXの一眼レフしか持っていないので、他社の機種でこのやり方が通じるかは知らない。

いまさらPENTAX K-rで恐縮だが、このようにボディ側にフォーカスモード切り替えスイッチがあるので、これをAFモードにする。なお、AFモードはAF.Sにしておく。AF.Cだとフォーカスがあっていなくてもシャッターが切れるのでこの場合MFモードとあまり変わらない。

そもそもなぜマニュアルフォーカスレンズをつけたらMFモードにしなければいけないのか。それはAFモードだと、フォーカスが合わないとシャッターが切れないからだ。つまりAFモードでもしっかりフォーカスを合わせればシャッターは切れる。つまり、

シャッターボタンを押しっぱなしにして、フォーカスリング回せば、フォーカスが合った瞬間自動的にシャッターが切れるのだ。この方法は意外と使い勝手がいい。試してみてはいかかだろうか。

Instagramと正方形写真の歴史

Instagramの写真は基本正方形である。最近は長方形フォーマットの投稿もできるようになっているが、それはスマホのカメラで予め撮影しておいた写真に限られ、リアルタイムで撮影する写真はいまでも正方形に限定されている。この理由についてだが、コダックのインスタマチックや、ポラロイドのインスタントカメラをリスペクトした結果と言われているらしい。

インスタマチックは、正方形画角のカートリッジ式125フィルムを採用したカメラで、35mmフィルムにくらべて取扱いが容易であり、子供や女性向けに安価なモデルが各社から販売されていた。発売は1963年だが、1970年代後半には姿を消していた様に思う。125フィルムをさらに小さくした110カートリッジフィルムを使うカメラがその後流行ったけど、これは正方形画面ではなかった。

ポラロイドのインスタントカメラは、フィルムを引き伸ばしてプリントするのではなく、その場で完成プリントが出来上がるもので、メジャーな規格ではおおむね8cm四方の正方形に写る。なお、一般的なポラロイドフィルムは、正方形の画面の下に、一方向だけ大きな余白がある。この部分に現像液が仕込まれていて、ロールで排出される際に撮影面に押し出されて現像される仕組みになっている。なので撮影面が正方形なのはひょっとするとこの余白を作るためだったのかもしれない。

インスタマチックがなぜ正方形だったのかについては、これが登場した当時、二眼レフカメラが普及しており、この形態のカメラの一般的な画面が6cm×6cmの正方形であり、カメラを使う人々が正方形画面に慣れていたという事があるらしい。戦前から35mmフィルムを使うライカなどのコンパクトカメラは製造されていたが、精密な35mmカメラは比較的高価であり、単純な二眼レフはインスタマチックが登場した1960年代、民間に随分普及していた。そもそも1900年にコダックが発売した「ブローニー」というカメラが6cm×6cmというフォーマットを採用しており、フィルムカメラの歴史の初期から正方形フォーマットは結構主流の一つだったのだ。

二眼レフで撮影した写真。Flexaret V, KODAK PORTRA400VC

ではなぜすたれてしまったのか。これはおそらく35mmが普及しすぎてしまったのだと思う。120フィルムで6×6の写真を撮ると、一本12枚しか撮れない。35mmなら36枚まで普通に撮れる。中版フィルムの画質の良さも、フィルム自体の改良で35mmで十分な解像度を得られるようになる。カメラ自体小型にできるため取り回しが良い。インスタマチックがでてきた頃、2眼レフを使っている人も、使っていた人も多かったかもしれないが、すでに35mmが普及し始めており、子供のための入門カメラ的に売れたものの、主流になることはなく消えていった。ポラロイドに関しては、その場で確認できるという利点があったために特定用途で使われ続け、デジカメの登場まで寿命を延ばすことになったが、今はすでにポラロイド社自体がデジカメにプリンターを内蔵する機種に切り替えてしまい、極めてマイナーなものになっている。

35mmフィルムは映画用のものを写真に流用したのが始まりだが、これを使ったライカが24mm×36mm、長方形画面のカメラを作った。このサイズが現代まで踏襲されている。まあ、人の目は左右2つあって、基本横の視界が広いので、画角が横長であるのは一応合理的なんである。

で、Instagramがかつてわりと普通に使われていたけどいまではほぼ消え去った正方形写真を復活させたのは、一種のノスタルジーであるわけで、これはあのアプリが最初から装備していた各種レトロフィルム調フィルター群によっても明らかだ。ただ、正方形画面には、実際にスマホにおいて非常に有利な点がある。スマホというのはなまじ縦にしても横にしても画像をフィットさせて表示するものだから、撮影時の方向と違う向きにすると、写真がずいぶん小さくなってしまうのだ。ところが正方形なら、縦にしようが横にしようが大きさが変わらない。

ところで、富士フィルムはポラロイドと同じようなインスタントカメラを出しているが、後発であったこともあってか、画面が正方形ではなかった。ところが、2017年春に、新たに正方形画面のフィルムとカメラを販売するという発表があった。